Generell müsste die Frage natürlich erweitert werden um “…und ist das sinnvoll?…”

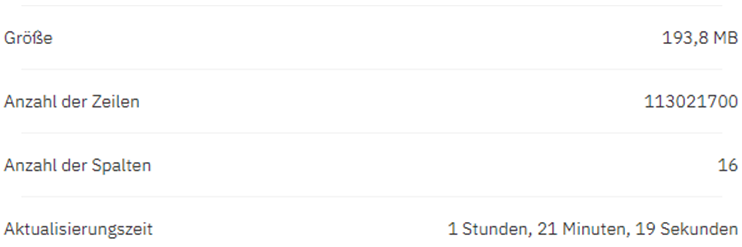

Machen wir doch mal einen Test und laden über 110 Millionen Datensätze in ein Dataset. In diesem Fall hat Cognos Analytics with Watson (Version 11.2.1) in einer Stunde und 21 Minuten geladen. Die Ladezeit hängt hier natürlich auch an dem darunter liegendem SQL (was in diesem Test über ein Kreuzprodukt verbundene Tabellen waren um die Anzahl der Zeilen zu generieren).

Geladen wurden 16 Spalten mit 11 Attibuten und 5 Kennzahlen:

Im Cognos Filesystem wurde eine Parequet-Datei in der Größe von 193 Megabyte erzeugt.

Nach dem Laden haben wir einige Tests auf der Datei im Reporting und im Dashboard durchgeführt. Das Aggegieren der Kennzahlen funktioniert tatsächlich in wenigen Sekunden. Wird aber ein Bericht auf Einzeldatensätze erstellt und das automatische aggregieren nicht ausgeschaltet, lässt sich Cognos ein paar Minuten Zeit um die Berichtsergebnisse anzuzeigen.

Wie verhält es sich bei Reports mit Filtern?

Das ist überraschend schnell! Werden aus dem Dataset Berichte erstellt, die über Filter z.B. nur 10.000 Datensätze zurückgeben, werden diese Daten in wenigen Sekunden geliefert.

Fazit: Auch wenn die Datasets eher mit weniger Datensätzen für schnelle Dashboards gedacht sind, ist es auch möglich große Datenmengen zu speichern und für Reports zu nutzen. Bei Umgebungen in denen kein ETL Prozess zur Verfügung steht also durchaus eine Alternative.